DOI: 10.1002/advs.202408610

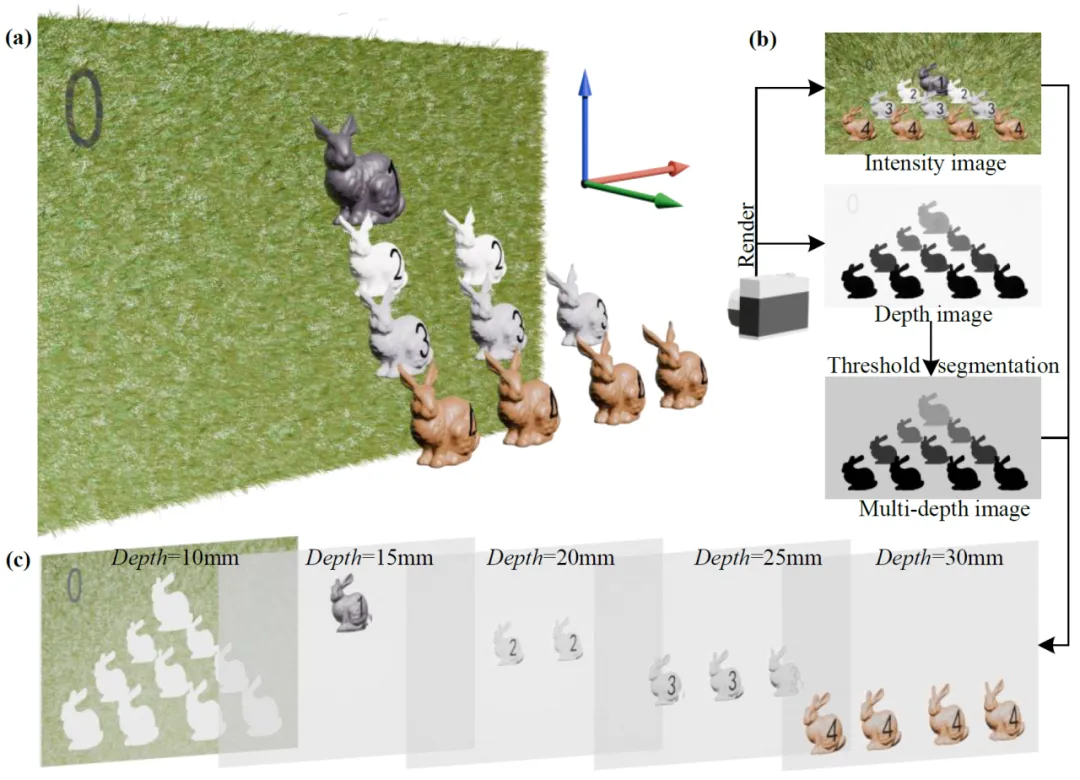

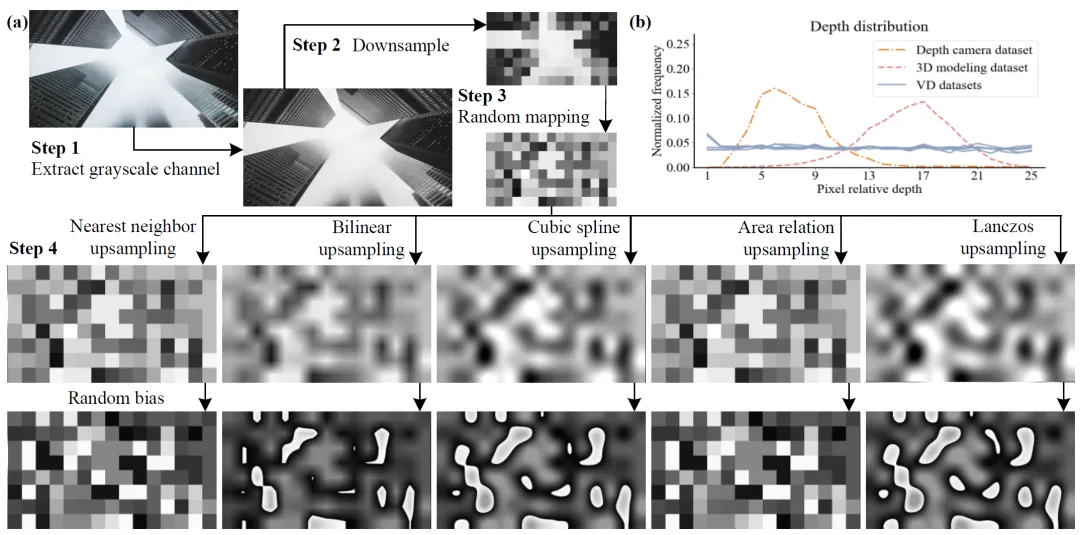

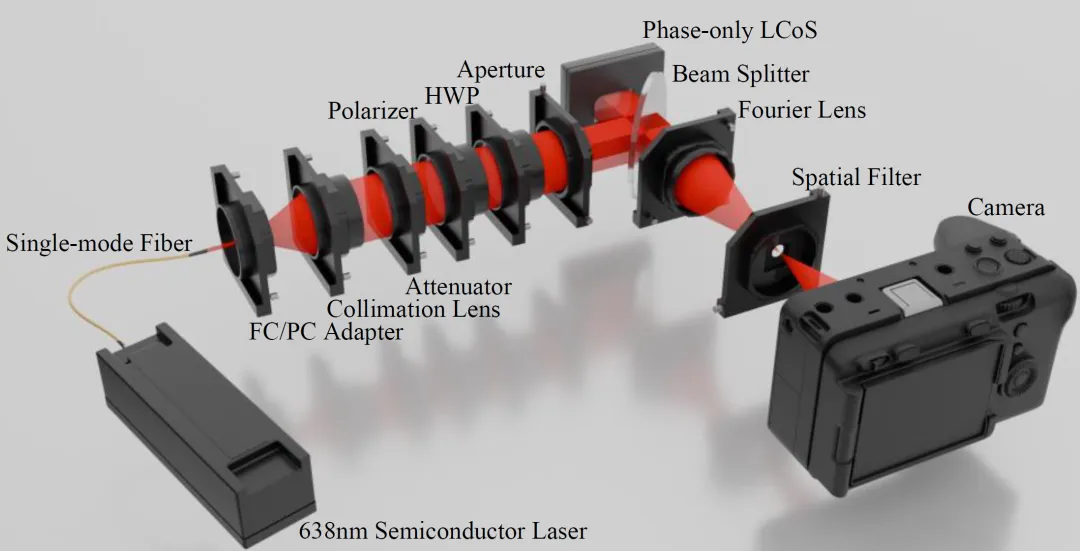

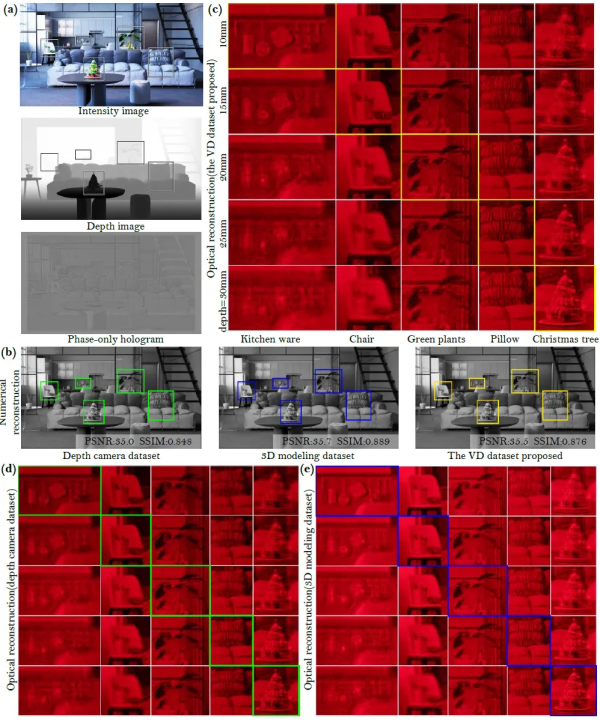

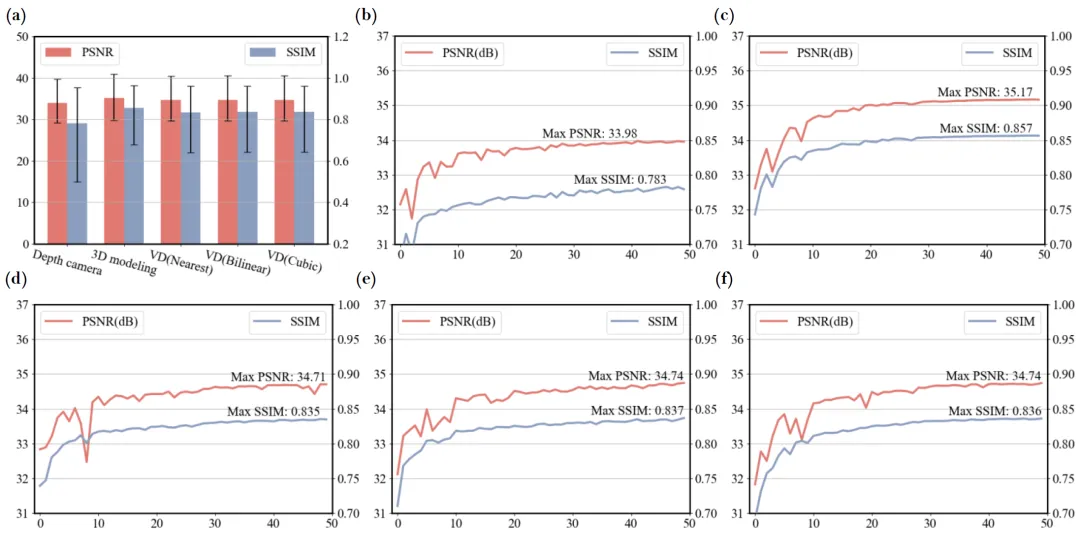

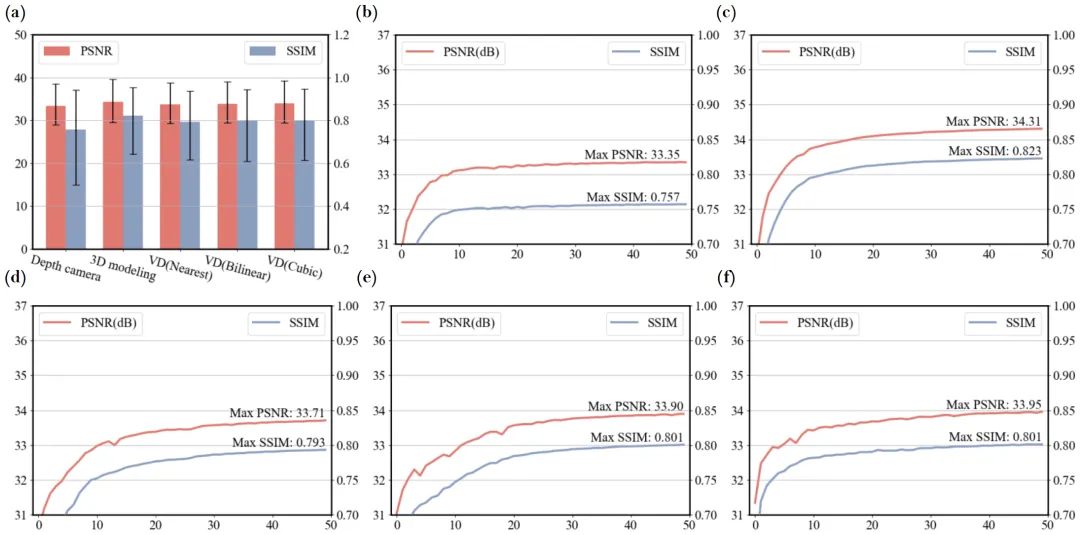

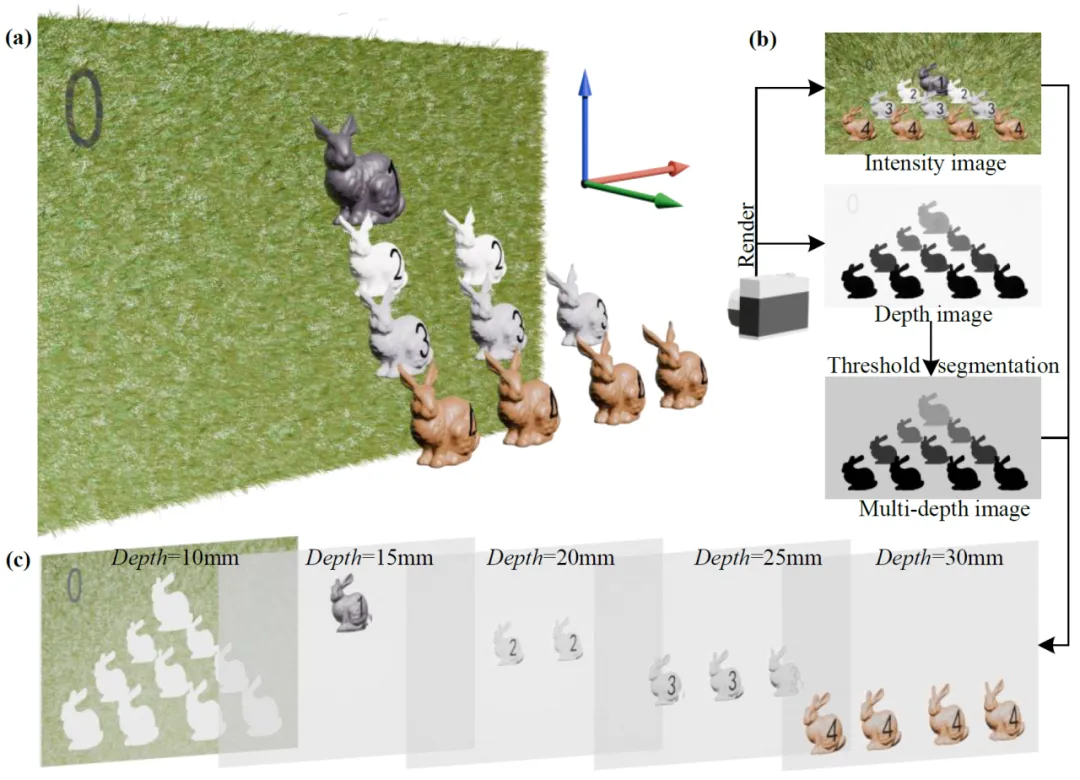

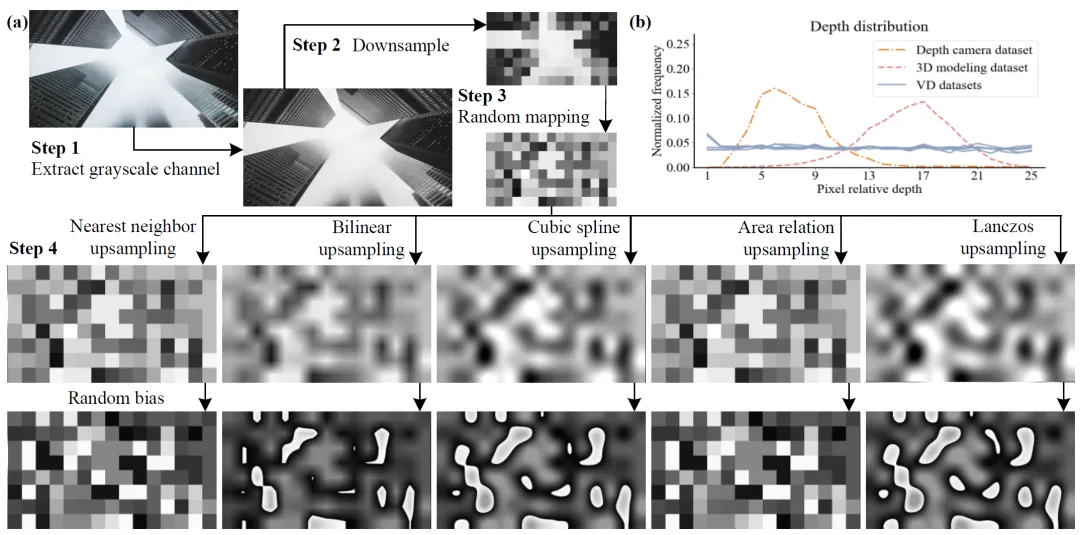

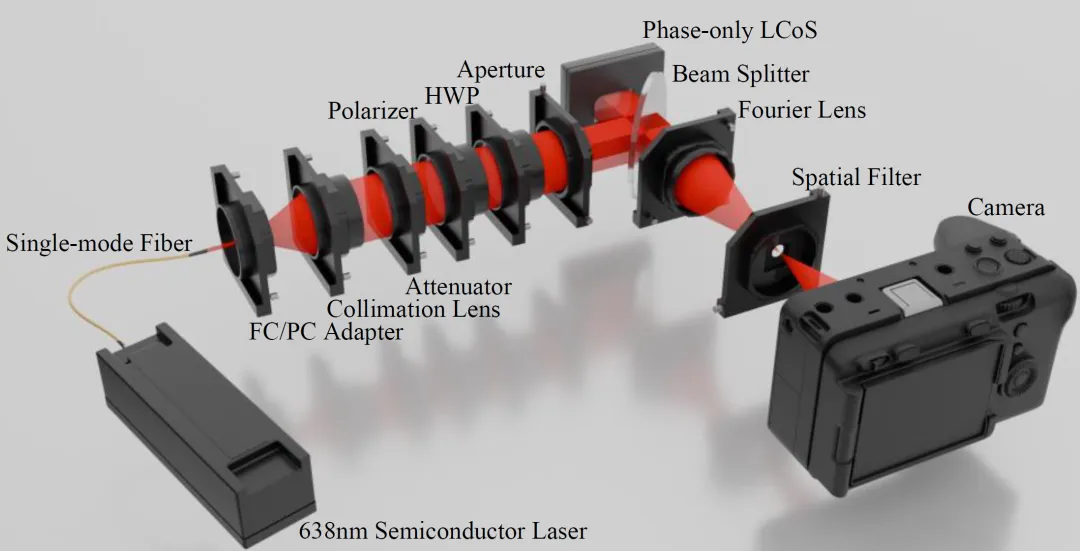

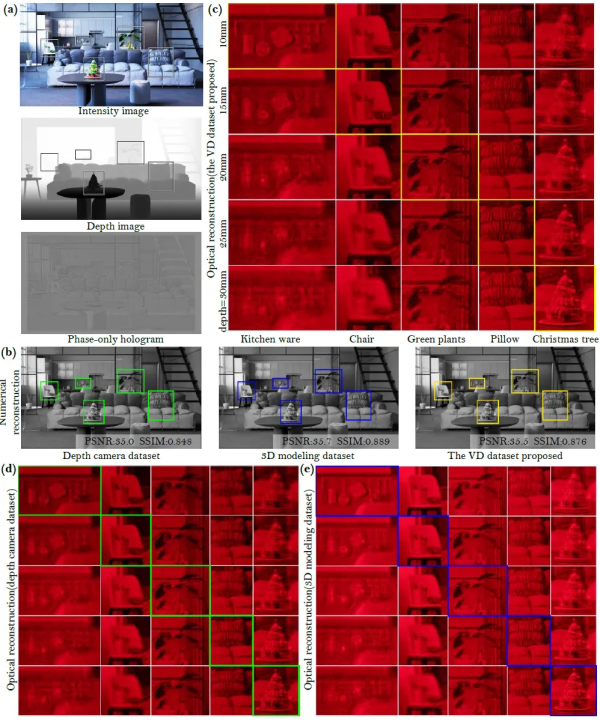

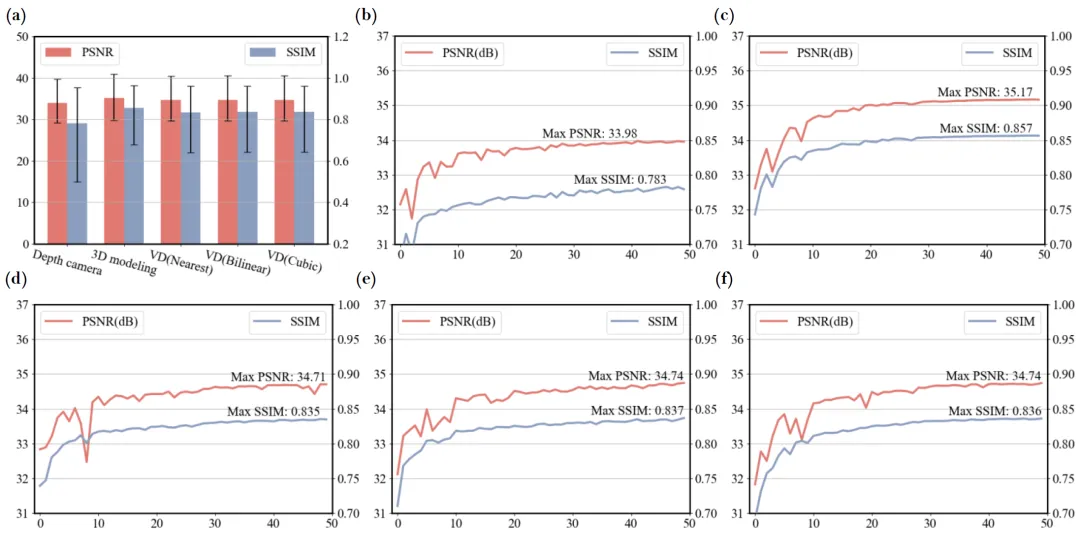

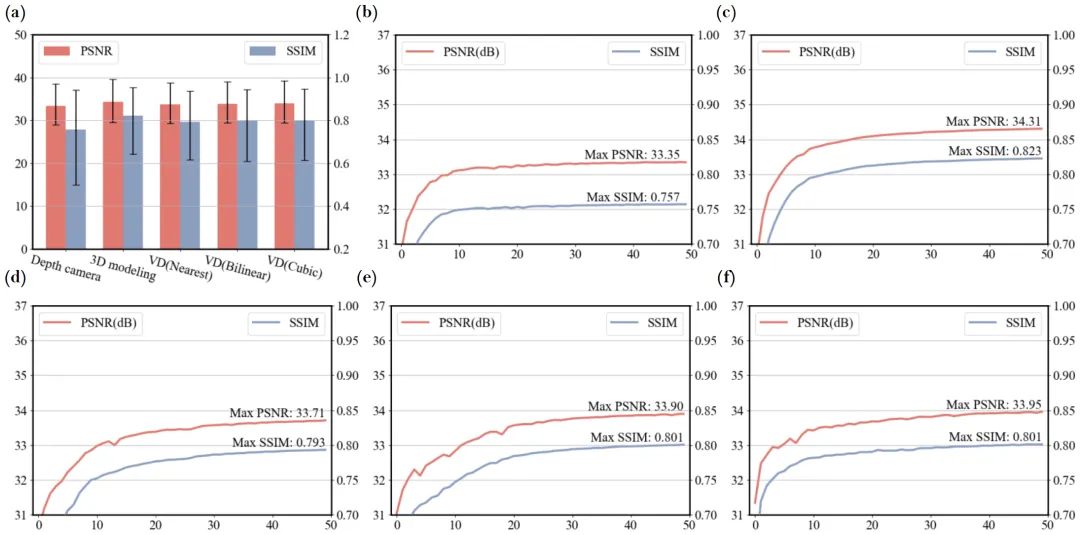

全息三維顯示技術通過干涉記錄與衍射重建,能夠捕捉完整的光場信息,提供包括聚焦、雙眼視差和運動視差等視覺線索,廣泛應用于醫療、工業檢測、教育和娛樂等領域。傳統的光學全息圖需要復雜的操作步驟,而計算機生成的全息圖(CGH)則克服了這些限制,能夠精確呈現深度信息并將實現動態實時顯示。近年來,深度學習在全息圖生成中的應用取得了顯著進展,尤其是在相位編碼全息圖的生成上。利用卷積神經網絡(CNN)使用3D數據集進行訓練,能夠快速生成高質量的相位全息圖,顯著提高了處理速度與圖像質量。然而,由于高質量3D數據集的缺乏,現有方法仍面臨著數據多樣性與計算資源的挑戰。 陸軍裝甲兵學院、北京郵電大學和陸軍工程大學的研究人員聯合提出了2D圖像數據集訓練CNN生成3D多深度全息圖的新方法。針對神經網絡編碼能力與深度分布的關系,提出了一種以2D圖像數據集用于3D多深度全息圖生成的新方法。研究基于DIV2K數據集,應用隨機映射和重采樣方法(RMRM)為數據集分配虛擬深度(VD)值,確保深度分布的復雜度和均勻性。隨后,采用卷積神經網絡(CNN)架構,結合角譜法(ASM)計算多深度衍射場,生成高質量的相位全息圖。此方法突破了傳統深度與強度分布之間的特定關系,通過均勻深度與2D數據集多樣化強度的結合,提高了網絡的編碼和泛化能力。該研究為全息圖生成領域帶來了創新思路,解決了該領域缺乏高質量3D數據集這一難點問題,提升了計算效率和圖像質量。該研究成果發表在國際權威學術期刊《Advanced Science》。 圖1. 生成多深度場景。(a)3D場景,(b)強度圖像、深度圖像和多深度圖像,(c)多深度場景。如圖1、圖2所示,三維場景在CNN編碼全息圖訓練過程中,深度圖像承擔了兩個重要功能:首先,深度圖像在輸入到卷積神經網絡(CNN)之前,負責對復振幅進行分割,從而使得衍射場能夠在每一層進行逐層計算;其次,深度圖像將不同深度下重建的復振幅堆疊起來,然后再進行損失函數的計算。值得注意的是,這兩個功能的實現與CNN內部的可優化參數無關,因為這些功能不依賴于CNN的梯度優化過程。通過這一點的分析,得出了一個反直覺的結論:神經網絡的編碼能力與強度和深度的分布密切相關,但與強度和深度之間的對應關系并無直接聯系。這意味著,盡管網絡通過不同深度的信息來構建和重建幅度圖像,但它并不需要學習深度和強度之間的具體映射關系。神經網絡的核心能力在于利用深度圖像作為工具來輔助衍射場的計算和重建,從而在編碼過程中對復雜振幅的處理更加靈活且高效。 圖2. 多深度純相位全息圖CNN模型訓練。(a)反向衍射場的計算,(b)CNN編碼純相位全息圖,(c)通過多深度重建得到焦疊圖像,(d)計算U2反向衍射場,(e)得到一個深度的對焦像素。基于此,該研究提出了一種基于隨機映射和重采樣方法(RMRM)的虛擬深度(VD)生成技術(圖3),旨在為2D圖像賦予深度信息以用于CNN訓練,以生成3D多深度全息圖。實驗表明,RMRM生成的虛擬深度圖像在深度層分布上具有適度的復雜性,同時保證的不同深度的均勻性,與傳統深度相機數據集相比,具有顯著的統計優勢。該方法不僅適用于快速生成高質量深度圖像數據集,而且由于其簡便的計算過程,適合集成到資源受限的硬件系統中。 圖3. RMRM方法實現RGB圖像生成虛擬深度(VD)。(a)Step 1提取灰度通道,Step 2對圖像進行下采樣,Step 3隨機映射,Step 4對映射值進行上采樣疊加隨機偏差,(b)深度分布統計直方圖表明,相對于深度相機數據集NYU和3D建模數據集,VD數據集在25個深度層上像素分布更為均勻。基于CNN的全息圖重建過程,重點討論了不同數據集對重建質量的影響。通過三種數據集(深度相機數據集、3D建模數據集及本研究提出的VD數據集)進行對比實驗,評估多深度全息圖的質量(圖5、圖6、圖7)。實驗結果顯示,VD數據集在PSNR和SSIM指標上表現最佳,且與數值重建的圖像質量高度一致。通過三維室內場景和測試圖案的光學與數值重建質量對比,驗證了所提方法在處理復雜場景中的有效性(圖8、圖9)。此外,實驗還表明,數據集的強度與深度分布對于神經網絡全息編碼能力有重要影響。 圖5. 三個數據集上訓練的CNN模型在室內三維場景的數值和光學重建對比。圖6. 三個數據集上訓練的CNN模型在二值分辨率靶場景的數值和光學重建對比。圖7. 三個數據集上訓練的CNN模型在二值網格場景的數值和光學重建對比。圖8. 偏真實場景測試集(包含20個不同類型場景的RGB-D),不同數據集訓練神經網絡模型的PSNR和SSIM。 圖9. 二值場景測試集(包含20個二值場景的RGB-D),不同數據集訓練神經網絡模型的PSNR和SSIM。該研究表明,通過使用傳統的2D數據集,可以利用CNN生成3D多深度全息圖。數值和光學實驗結果表明,基于VD數據集訓練的神經網絡能夠重建高質量的場景,并在3D深度聚焦上表現出色。調整參數(如縮放、閾值和插值)進一步提升了3D重建效果,并在統計結果上超越真實場景數據集的表現。本文的研究為全息圖像重建提供了新的視角和方法,具有重要意義。Advanced Science 是Wiley旗下創刊于2014年的優質開源期刊,發表材料科學、物理化學、生物醫藥、工程等各領域的創新成果與前沿進展。期刊為致力于最大程度地向公眾傳播科研成果,所有文章均可免費獲取。被Medline收錄,PubMed可查。最新影響因子為17.521,中科院2021年SCI期刊分區材料科學大類Q1區、工程技術大類Q1區。